Un equipo de neurocientíficos de la Universidad de Stanford, liderados por Frank Willett , ha identificado por primera vez de manera distintiva la actividad cerebral relacionada con el habla interna (el monólogo silencioso en la mente de las personas) y la han decodificado con éxito con hasta un 74% de precisión.

Aunque otros investigadores, y el propio equipo de Stanford, llevan años desarrollando sistemas para traducir señales neuronales a palabras y permitir expresarse a personas que han perdido esta capacidad, hasta ahora se habían centrado en el ‘habla intentada’, es decir, en la activación de las áreas motoras cuando una persona hace el intento de expresar las palabras. Pero dentro del área motora hay otra capa de actividad neuronal, que es la que se pone en marcha cuando pensamos algo que no queremos decir en voz alta.

Pensamientos con contraseña

Los autores de este nuevo estudio, publicado en la revista Cell , aseguran que su interfaz cerebro-computadora (BCI) discrimina y decodifica la señal específica del “habla pensada”, lo que abre posibles vías para ayudar a pacientes que están “enclaustrados” y ni siquiera pueden activar las vías motoras. Al mismo tiempo, los investigadores se han dado cuenta de que esto tiene implicaciones que afectan a la propia privacidad del pensamiento, por lo que han ideado un sistema para proteger su lectura con una contraseña, una palabra clave que solo conoce el paciente y que autoriza el acceso.

El sistema solo empieza a traducir la actividad neuronal en palabras una vez que detecta una contraseña, similar a cuando ingresas una clave para usar tu teléfono o portátil

Erin Kunz — Autora principal del artículo

El sistema que impedía que la BCI decodificara el habla interna, revelan los autores, se desbloqueaba temporalmente con la frase “ chitty chitty bang bang ”. Cuando los usuarios pensaban en esta clave, el sistema reconocía la contraseña con una precisión superior al 98%. “El sistema solo empieza a generar resultados decodificados (a traducir la actividad neuronal en palabras) una vez que detecta una contraseña, similar a cuando ingresas una clave para usar tu teléfono o portátil”, explica a elDiario.es Erin Kunz , autora principal del artículo. “O quizás de forma más parecida, cuando usas Siri o Alexa y dices ‘Hola, Alexa’: solo responde cuando dices una frase específica primero; de lo contrario, te ignora”.

Palabras imaginadas

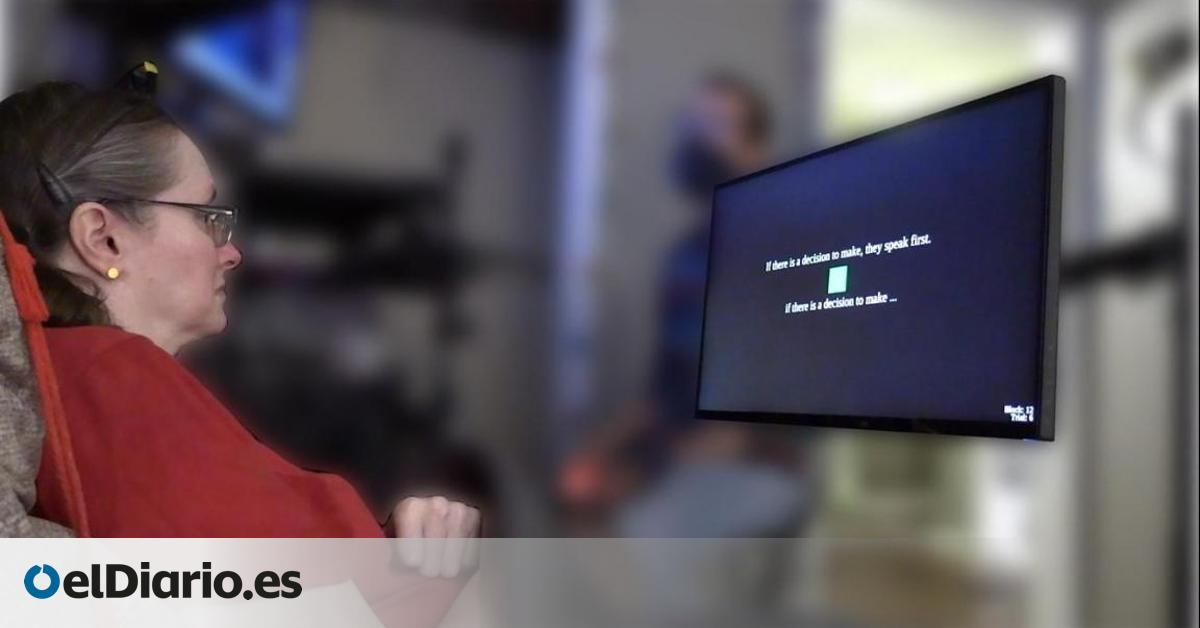

Para el estudio, el equipo registró la actividad neuronal mediante microelectrodos implantados en la corteza motora (la región cerebral responsable del habla) de cuatro participantes con parálisis grave causada por esclerosis lateral amiotrófica (ELA) o un ictus del tronco encefálico. Los científicos pidieron a los participantes que intentaran hablar o imaginaran que pronunciaban un conjunto de palabras y descubrieron que el intento de hablar y el habla interna activan regiones superpuestas en el cerebro, pero distintas.

Utilizando los datos del habla interna, el equipo entrenó modelos de inteligencia artificial para interpretar estas palabras. En una demostración de prueba de concepto, la BCI pudo decodificar oraciones imaginadas de un vocabulario de hasta 125.000 palabras con una precisión de hasta el 74%. La interfaz también pudo captar lo que a algunos participantes del habla interna nunca se les indicó que dijeran, como números, cuando se les pidió que contaran los círculos rosas en la pantalla.

Para las personas con discapacidades motoras y del habla graves, las BCI capaces de decodificar el habla interna podrían ayudarles a comunicarse con mucha más facilidad y naturalidad

Erin Kunz — Autora principal del artículo

“En primer lugar, queríamos explorar una importante frontera ética y técnica: ¿podrían estos sistemas decodificar palabras que una persona nunca tuvo la intención de decir en voz alta?”, resume Kunz. “En segundo lugar, nuestro objetivo era hacer que las BCI fueran más accesibles y cómodas para usuarios con discapacidades motoras y del habla graves. Muchos de nuestros primeros participantes (como personas con ELA) compartieron que intentar vocalizar mientras usaban el sistema era agotador”.

En general, el equipo descubrió que, si bien el habla intentada y el habla interna imaginada producen patrones similares de actividad neuronal en la corteza motora, eran lo suficientemente diferentes como para distinguirse con precisión. “Esta es la primera vez que logramos comprender cómo se ve la actividad cerebral cuando simplemente pensamos en hablar”, resume Kunz. “Para las personas con discapacidades motoras y del habla graves, las BCI capaces de decodificar el habla interna podrían ayudarles a comunicarse con mucha más facilidad y naturalidad”.

“Impresionante y significativo”

Kunz reconoce que no es el único intento de decodificar el habla interna (o imaginada) y recuerda que el equipo de Sara Wandelt , investigadora del Instituto Tecnológico de California (Caltech), decodificó palabras individuales , aunque en una región diferente del cerebro. Consultada por elDiario.es , Wandelt reconoce que este nuevo estudio es un avance técnico “impresionante y significativo” hacia las BCI que decodifican el habla interna, permitiendo potencialmente que las personas con parálisis se comuniquen de una manera que resulte más fácil y natural.

Todos los participantes prefirieron este enfoque de habla interna al intento de hablar, ya que requería menos esfuerzo físico y evitaba la articulación visible

Sara Wandelt — Investigadora del Instituto Tecnológico de California (Caltech)

“En nuestros propios estudios, demostramos que las palabras habladas internamente podían decodificarse desde la corteza parietal posterior”, señala Wandelt. “El presente trabajo muestra que la corteza motora también transporta señales para el habla interna, lo que permite la decodificación sin pedir a los participantes que intenten o imiten el habla, lo que a veces puede resultar engorroso o agotador”. En su opinión, haber logrado una decodificación fiable de siete palabras diferentes únicamente a partir del habla interna en cuatro personas, constituye un resultado contundente. “Todos los participantes prefirieron este enfoque de habla interna al intento de hablar, ya que requería menos esfuerzo físico y evitaba la articulación visible”, apunta.

Proteger los datos neuronales

Otros especialistas, como el neurocientífico español Rafael Yuste , se muestran escépticos con el resultado. “Se trata de un estudio incremental, que sigue trabajos anteriores, como el de Chang en 2023 , pero añadiendo más pacientes”, explica a elDiario.es . “La diferencia entre este paper es que, según ellos, ahora descodifican no solo el ‘habla intentada’, sino el ‘habla interna’, pero yo creo que es una diferencia esencialmente semántica”. Respecto a la privacidad del pensamiento, cree que no hay ningún riesgo en utilizar estos métodos en pacientes, aunque sí los habría si se utilizan métodos parecidos en dispositivos comerciales, por lo que es urgente legislar para proteger los datos neuronales.

No se cómo evitarán el riesgo de que la máquina traduzca todos mis potenciales pensamientos en hablar sin que yo quiera externalizarla

Antonio Oliviero — Jefe de Neurología del Hospital Nacional de Parapléjicos de Toledo

Antonio Oliviero , jefe de Neurología del Hospital Nacional de Parapléjicos de Toledo (HNP), también tiene dudas sobre lo que sucederá con la privacidad una vez que la tecnología de traducción del ‘habla pensada’ sea de uso común. “No se cómo evitarán el riesgo de que la máquina traduzca todos mis potenciales pensamientos en hablar sin que yo quiera externalizarla”, asegura. “El tema del habla intentada y el habla pensada es históricamente un problema, pero si tienes en cuenta que una de las cosas que les sucede a los pacientes que tienen alteraciones frontales es que no inhiben el habla pensada, y pueden decir todo lo que se le ocurre en la cabeza, habría que cuidar la codificación”.

Para Juan de los Reyes Aguilar , investigador del HNP, lo relevante es que al implantar estos microelectrodos en el área motora, los autores consiguen descifrar palabras que la persona piensa, lee, escucha, pero no quiere decir. “Eso es lo que hace nuestro cerebro cuando tú estás pensando cosas que puedes o no puedes decir y tu corteza prefrontal te da o no te da permiso, se llama inhibición”, explica.

Lo novedoso, para el experto, es que eso genera un posible problema en el futuro, si los implantes pueden estar decodificando lo que una persona piensa. “Esto les obliga a inventarse una especie de llave entre la palabra pensada que no se quiere ejecutar y las palabras que sí se quieren ejecutar”, concluye. “Y tendremos que incorporar estos sistemas, para que las personas que tienen problemas de comunicación solo comuniquen lo que quieren y se callen lo que no quieren, como hacemos los demás”.

ElDiario.es

ElDiario.es Blaze Media

Blaze Media Ann Arbor News Life

Ann Arbor News Life Washington Examiner

Washington Examiner  AlterNet

AlterNet Essentiallysports Tennis

Essentiallysports Tennis The Atlanta Journal-Constitution Sports

The Atlanta Journal-Constitution Sports The US Sun Entertainment

The US Sun Entertainment